A/B-tester, d.v.s. när man testar en variant mot en annan under samma period mot samma målgrupp (men givetvis olika individer), är kanske det bästa och enda sättet att verkligen utvärdera om en idé funkar eller inte. Datadrivet ska det vara. Magkänslornas tid är förbi.

När man jobbar affärsutveckling och kanske särskilt med Growth Hacking-metodiken, så handlar det mycket om att testa olika idéer. Det är oerhört lätt som affärsutvecklare att falla in i ”Ja, men detta är ju en no-brainer.” och ”Vi vet att detta kommer att funka.” o.s.v.

Jag vågar påstå att det enda vi vet, är att vi inte vet nånting. Det kan vara små subtila skillnader som på ett psykologisk plan gör enorm skillnad och som vi aldrig hade kunnat förutspå. Det finns egentligen bara ett bra sätt att angripa detta; A/B-tester.

Det absolut mest klassiska A/B-testet som jag tror att alla i min roll har dragit som exempel är ”blå eller grön knapp”. Tänk dig att ditt företag har en webshop med en gröna köp-knappar. Någon av dina medarbetare har googlat lite och läst att blått tydligen ska locka folk att handla mer. Och så byter man till blåa knappar över en natt. Kommande vecka kollar man hur många som har klickat på Köp-knapparna och ser att det är fler än tidigare! Bra eller hur?! Men finns det en direkt kausalitet – orsakssamband – mellan färgen på knapparna och antalet klick, eller kan det vara andra orsaker? Kanske var det efter löning och fler var i köpläge? Kanske gick det en riktad facebookannonsering samtidigt, som ökade konverteringsgraden? Kanske var helt andra besökare inne på hemsidan? Eller var det kanske faktiskt färgen? Det är omöjligt att svara på, eftersom man inte gjorde ett A/B-test.

Så istället skulle man, via t.ex. verktyg som Google Optimize (gratis) eller Optimizely (ganska dyrt), ha kört ett A/B-test. D.v.s. 50% av besökarna ser den blåa knappen och 50% ser den gröna knappen. Man kör testet mot exakt samma målgrupp (alla besökare) och under exakt samma tidsperiod. En eventuell facebookkampanj eller löningsfredag påverkar båda segmenten på exakt samma sätt och skevar inte resultatet alls.

Hur länge behöver man köra ett A/B-test?

Hur länge man ska köra testet beror på många faktorer, men främst hur många klick på knapparna ni faktiskt har. Ju fler klick, desto kortare kan köra testet. Men räkna med åtminstone 2 veckor.

Man brukar vilja komma upp i en konfidensnivå på åtminstone 95% eller helst 99% (dvs att bara 1/100 utförda tester kommer att ge felaktiga resultat beroende på slumpen). Det går att räkna ut urvalsstorlek med verktyg på nätet, men det finns egentligen ingen anledning för du kommer att se det direkt i Google Optimize!

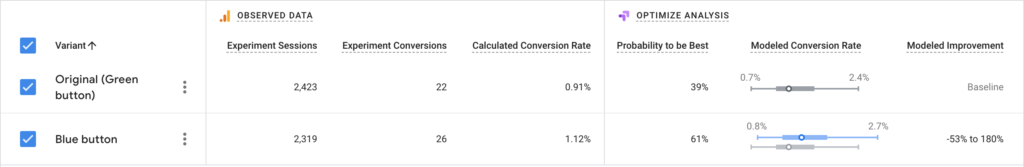

I ovanstående exempel, så har vi kört testet i 6 dagar. Vi har relativt många sessioner, men eftersom det är en ganska undangömd knapp, så har vi väldigt få klick på den. Den gröna knappen har 22 klick på 2.423 sessioner och den blåa knappen har 26 klick på 2.319 sessioner. Den blå knappen har alltså lite högre klickgrad med 1,12% mot 0,91% men eftersom antalet klick är så pass lågt så säger Google Optimize att det är 61% chans att den blåa knappen är bäst. Det är alltså än så länge alldeles för liten säkerhet i detta test och vi kommer att låta det köra vidare i en eller ett par veckor till, tills vi antingen har fått upp konfidensgraden eller tills vi helt enkelt konstaterar att skillnaden är så liten att det inte är värt ändringen av den anledningen.

Måste alla besökare ingå i testet?

I de flesta fall så vill man genomföra A/B-tester på så kort tid som möjligt för att snabbt lära sig något och då ta nytt beslut om ytterligare tester. Då behövs oftast alla användare för att komma upp i konfidens snabbt. Då är 50/50 oftast det bästa sättet. Men har man väldigt många besökare, eller vill testa något som kan potentiellt skaka om användarna rejält… Då kan det ibland vara lämpligt att köra testvarianten på en mindre del av användarna. Detta finns det stöd för i alla A/B-testverktyg och så även i Google Optimize. Man väljer isåfall ut att t.ex. 10% av besökarna ska få variant B och resten får det gamla vanliga utseendet, variant A. Verktyget räknar sen själv ut och presenterar representativa resultat. Men mitt grundtips är att alltid testa på 50/50.

Double-down – testa vidare på det som funkar

Uttrycket Double-down kommer väl ursprungligen från kortspelet Black Jack, där man mitt under pågående hand, kan dubbla sin insats för att man tror starkt på sin hand och på nästa kort. Inom Growth Hacking, så används begreppet med vissa likheter, och framför allt en tydlig skillnad; Inom Growth Hacking satsar vi aldrig på något vi ”tror på” utan endast på det vi ”vet genom testresultat”.

Vi leker vidare med det relativt simpla exemplet med ”blå eller grön knapp”. Efter att ha kört testet så pass länge att verktyget säger att det är 99% chans att den blåa knappen är den bästa, så väljer vi att implementera den på sidan för samtliga användare. Att nu göra fortsatta experiment för att optimera den blåa knappen är att ”double-down on your success”. Vi kan t.ex. testa att skriva ”Lägg i varukorgen” istället för ”Köp”. Visar sig det vara bättre, så kan vi testa att på den numera blåa knappen med ”Lägg i varukorgen” gör runda hörn istället för raka hörn. Funkar även det så har vi nu en betydligt bättre konverterande blå knapp Lägg i varukorgen-knapp med runda hörn, mot den tidigare gröna Köp-knappen med raka hörn. Detta hade vi aldrig kommit fram till utan denna rad av A/B-tester.

Vänligen observera att detta är ett hypotetiskt exempel. Jag har ingen aning om runda hörn eller raka funkar bäst för din målgrupp och heller ingen aning om blå eller grön knapp lockar flest klick. Budskapet i denna artikel är just att vi inte vet nånting, och att allt måste testas!

Några fler konkreta exempel på A/B-tester du kan göra

Jag har nu använt den triviala knappen i mitt exempel. Det finns förstås mycket mer att A/B-testa och som förmodligen betydligt större effekt än att laborera med färgen. Här kommer ett par exempel.

- Har du en hemsida med en funktion för att registrera sig till ert nyhetsbrev? Är det viktigt för er? Ligger den i sidfoten? Prova i ett A/B-test att lägga den i sidhuvudet för 50% av besökarna istället!

- Har ni ett komplicerat checkout-flöde med många fält för adress, leveransadress o.s.v. Prova att i ett A/B-test ta bort alla fält som ni inte absolut MÅSTE ha, och jämför churn-rate (hur många som hoppar av) i kassan.

- Syns sökrutan direkt i sidhuvudet eller har ni bara ett litet diskret förstoringsglas? Enligt Google’s UX Playbook for Retail så konverterar synliga sökrutor betydligt bättre. Kör ett A/B-test med en variant med synlig sökruta och en variant med förstoringsglas. Mät gärna skillnaderna både i användning av funktionen OCH antal transaktioner. Skulle den variant med flest sökningar ha minst antal transaktioner, så bör ni se över sökresultaten.

Det finns såklart många fler och nu blev det ganska mycket fokus på e-commerce. Men webben har verkligen fördelen att det är otroligt lätt att genomföra A/B-tester. Och det finns riktigt bra gratisverktyg, såsom nämnde Google Optimize.

Jag skrev tidigare att det enda vi vet är att vi inte vet nånting. Jo, en sak till vet jag. Att det är otroligt dumt att inte A/B-testa. Har du börjat med A/B-testning? Vilket verktyg använder du? Kommentera gärna här nedan!